太平洋科技 行业

不愧是中国机器人,乒乓打得太6了

量子位

整合编辑:太平洋科技

发布于:2025-10-09 10:39

量子位

整合编辑:太平洋科技

发布于:2025-10-09 10:39

-

清华姚班本科生苏智研发的人形机器人G1在乒乓球领域表现出色,通过模型规划与强化学习实现亚秒级反应连续对打。机器人成功回球率高达96.2%,击中106次连拍超越休闲玩家水平。采用OptiTrack摄像头追踪毫米级精度,结合全身控制器生成类人动作参考。挑战快节奏、极限时间窗口的交互需求,展示了卓越的感知预测和运动执行能力。

|

机器人打乒乓球,这(zhei)您受得了吗? 关键玩的还都是高难度:并步接球!

0.42秒极限反应回击扣球!

最高还能对拉106拍!

打不过,反正我是打不过。 这位乒乓球场上的机器人高手,出自清华姚班本科生苏智(师从吴翼教授)的最新论文——《HITTER: A HumanoId Table TEnnis Robot via Hierarchical Planning and Learning》。 在这篇论文中,研究者们提出了一套结合模型规划与强化学习的分层框架,实现了人形机器人在亚秒级(sub-second)反应下的稳定连续对打。 这是怎么做到的? 基于规划与控制的分层框架总的来说,为了教机器人打乒乓球,研究团队提出了一个将高层规划与低层控制分开处理的框架。 其中,在高层规划中,基于模型的规划器(model-based planner)能够导航球的轨迹,并预测击球位置、速度和时机。 在低层框架中,基于强化学习(RL)的全身控制器,能够根据规划器的预测,生成协调的手臂和腿部动作来执行与人类相似的打击动作。

具体来说,研究团队直接将宇树G1的手掌变成了乒乓球拍,并让它站在一张标准尺寸的乒乓球台上进行训练。 在感知方面,研究采用了九个OptiTrack摄像头(运行频率为360 Hz)来追踪球的位置,这达到了毫米级的精度。 在规划方面,基于模型的规划器在每个时间步接收球的位置数据,并预测球拍的击球位置、速度和时机。 这些预测被交付给全身控制器,以生成宇树G1所需的击球时机和球拍速度。 之后,机器人根据强化学习不断调整击球策略,提高运动表现。 此外,为了鼓励机器人做出类似人类的挥拍动作,研究人员还在策略训练中加入了人类动作参考(正手和反手)。 通过人类动作参考进行训练,机器人产生了与人类动作非常相似的击球行为:例如下图中机器人击球时的腰部旋转。

在真实世界的实验中,团队向机器人投掷了26个球,机器人成功回球24次,击中后未回球1次,完全失球1次,达到了96.2%的击球率和92.3%的回球率。

而且,就像我们开头提到的,G1在与人类对手对打时,实现了多达106次的连续击球,这一连拍远远超过了休闲人类玩家的水平。 此外,G1还表现出了回击扣球的能力。 最后,值得一提的是,除了与人类进行对战,机器人也可以在完全自主的匹配环境中持续进行对战。

为什么是乒乓球?在前段时间的机器人运动会上,我们已经看到了不少机器人参与的运动项目(如跑步、拳击、足球等)。 不过,这些运动往往留给机器人较长的调整与反应时间。 而在现实生活中,机器人常常需要在动态环境下与快速移动的物体交互,这种交互从根本上讲更难: 因为它们不仅需要各个关节的协调控制,还需要在极限时间测量内运行的精密感知-行动闭环,而乒乓球正是此类交互的绝佳例子。 相对于网球或羽毛球等运动,乒乓球的距离更短、攻防转换更快、反应时间窗口更小(球速超过5米/秒)。 这就意味着机器人系统必须在瞬间内完成感知、预测、规划和击球以及与移动或静态的不同操作。 更难的是,成功的击球需要敏捷的全身运动,包括快速摆动手臂、转动腰部、快速垫步和恢复平衡,以确保准确击球并为下一次打做好准备。 所以,打乒乓球,对人形机器人来说,还真不是一件容易的事。 已经开始期待下一次的机器人运动会了!

本文来源:量子位 |

IT百科

网友评论

聚超值•精选

-

- 天钡游刃Z独显迷你电脑主机 高性能全新AMD R7台式整机双A组合RX6600LE显卡8G显存电竞游戏小主机 锐龙R7-7435HS+RX6600LE独显 准系统【无内存无硬盘】

- 满3000减200

-

¥3199.0

¥3399.0

- yOZE随身wifi6免插卡三网通【无需预存】移动wifi6随行无线上网卡便携式热点路由器笔记本电脑上网宝 升级版(充电款)太空黑+免插卡双天线(高速网)

- 券后省23

-

¥35.0

¥58.0

- 阿尔法蛋学生蓝牙耳机D1Pro 儿童耳机无线不入耳式网课学习辅助背书运动听歌头戴式D1 学生耳机D1 米色

- 满368减30

-

¥169.0

¥199.0

- 倍思apple pencil电容笔适用苹果ipad触控笔applepencil一代平板air触屏笔ipencil二代ipad pencil通用手写笔

-

¥168.0

¥198.0

- 臻火四禧 女财神电竞鼠标垫 fps游戏专用 大小号无畏契约 二次元动漫女生 坠 红火 小财神女 (360*300*5橡胶底)

- 券后省10

-

¥59.0

¥69.0

-

- 极度未知(HYPERX)飓风2升级款飓风3 头戴式游戏电竞耳机电脑耳麦 吃鸡游戏耳机 适配三角洲行动 【飓风3黑红】金榜精选丨DTS音效 头戴式游戏耳机

- 满1000减20

-

¥589.0

¥599.0

- 飞利浦无线投屏器 手机视频传输同屏器4K高清hdmi适用华为苹果安卓手机连电视机显示器投影仪车载 无线投屏器【横竖屏】

- 券后省0.9

-

¥161.1

¥179.0

- 山泽(SAMZHE)网线测试仪 多功能测线仪电脑网络水晶头电话线工程 家用智能测试测通器 黑色CS-50

- 券后省0.9

-

¥26.91

¥29.9

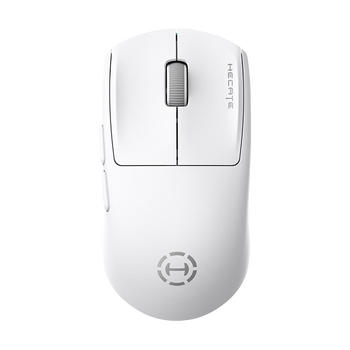

- 漫步者(EDIFIER)HECATE G1M无线有线蓝牙三模电竞游戏办公鼠标长续航12000DPI轻量化csgo吃鸡lol支持1K 机能白

- 券后省0.9

-

¥85.5

¥95.0

- 海泰炎龙系列H.T EX Slim MC 67mm适用佳能尼康索尼富士奥巴单反微单镜头12层镀膜MCUV滤镜0.7mm镜片

- 券后省0.9

-

¥269.1

¥299.0

-

- 奈特科尔【专业摄影气吹】cw20金属口袋摄影造型风扇多用途电脑单反相机镜头电驱吹气宝 黑色【100W无刷电机/98000转】

- 券后省0.75

-

¥298.5

¥398.0

- 闪极麦金塔35W氮化镓苹果17充电器iPhone16快充头PD20W18W适用iPhone15ProMax华为小米三星平板iPad

- 券后省12

-

¥97.0

¥109.0

- uiisii云仕U1有线耳机半入耳式吃鸡笔记本电脑四级听力高音质带麦

- 券后省12

-

¥27.0

¥39.0

- 神牛AD200proII闪光灯外拍闪光灯锂电池口袋便携外拍摄影补光灯单反相机高速TTL闪光灯 AD200proII【新增双色温造型灯】 标配【引闪器套餐需要备注相机型号】

- 券后省20

-

¥2160.0

¥2180.0

- 影石(Insta360)子弹时间配件【适配X3/X4/ONE RS/ONE X2】

- 券后省0.9

-

¥236.7

¥263.0

-

- ANKER安克30W冰点充 苹果17充电器type-c快充pd氮化镓适用iPhone16promax15/14apple手机iPad插头 白

- 券后省0.9

-

¥53.55

¥59.5

- 华为(HUAWEI)手表WATCH FIT 3【咨询享优惠】智能运动健康管理蓝牙通话轻薄大屏NFC门禁支付送男女士朋友礼物 幻夜黑【甄选定制表带+精美表盘】

- 满500减95

-

¥594.15

¥699.0

- 绿联双typec数据线ctoc适用苹果17/16iPhone15pro华为小米17/ipad电脑macbook充电线两头pd100w快充tpyec口

- 券后省2.8

-

¥9.9

¥18.7

- 倍思适用苹果17数据线PD20W快充线iphone14充电宝线短款器13promax手机12车载16加长2米15typec转lightning11

-

¥23.0

¥32.0

- Apple【准新机】苹果16promax iphone16promax 苹果16pro 国行 5G 手机 16Pro【沙漠色钛金属】 512GB【原装未使用+蓝牙耳机+豪华大礼包】

- 满5000减700

-

¥8558.0

¥8858.0

量子位

量子位