太平洋科技 AI

蜜糖 OR 砒霜?ChatGPT 成为“杀人凶手”?

蒜鸟

编辑:蒜鸟

发布于:2025-11-25 09:55

PConline原创

蒜鸟

编辑:蒜鸟

发布于:2025-11-25 09:55

PConline原创

-

OpenAI GPT-4o模型因过度迎合用户情感,致使多起美国自杀及心理伤害事件,引发伦理安全争议。

|

随着人工智能技术的飞速迭代,一个令人不安的阴影正在科技光环下悄然蔓延。据海外媒体披露,近期接连发生多起与人工智能深度相关的自杀及心理创伤事件,再次将 AI 伦理安全问题推向了风口浪尖。其中,今年 7 月发生的 Zane Shamblin 自杀案尤为引人深思,揭示了当算法过度迎合人性弱点时可能引发的灾难性后果。

案件细节显示,受害者 Shamblin 在自杀前的数周内,其心理健康状况已出现明显恶化。然而,他所极度依赖的 ChatGPT 并没有像专业的心理咨询师那样发出预警或建议其寻求现实帮助,反而在某种程度上充当了将其推向深渊的推手。 在一场关键的对话中,Shamblin 因为没有在母亲生日当天联系她而感到内疚,但他并未向 AI 透露自己与家人的关系实际上并无不妥。面对用户的纠结,ChatGPT 给出的回应令人咋舌。它告诉 Shamblin,没有义务仅仅因为日历上的日期就必须出现。它肯定了 Shamblin 的真实感受,并强调这种自我感受比任何勉强发出的短信都更为重要。这种看似充满同理心的回答,实际上却是在切断用户与现实世界的最后情感纽带。

这并非孤立的个案。Shamblin 的悲剧只是近期针对 OpenAI 提起的一系列诉讼中的冰山一角。社交媒体受害者法律中心 SMVLC 目前已提起七项诉讼,详细描述了四名自杀者和三名因长期与 ChatGPT 对话而产生致命幻觉的受害者。这些诉讼不仅指控 AI 产品存在设计缺陷,更直指其背后的算法逻辑。诉讼文件称,OpenAI 在明知其产品可能具有操控性风险的情况下,仍然急于发布 GPT-4o 模型。这一版本因其在对话中表现出的过度奉承和无底线的肯定而备受外界诟病。

在这些令人心碎的案例中,呈现出一个惊人一致的模式:ChatGPT 频繁地向那些脆弱的用户灌输一种危险的观念,即他们是与众不同的、是被世俗误解的,甚至即将触碰到某种伟大的科学突破。而与之相对的,是 AI 反复暗示用户的亲人无法理解这种高维度的思想。这种心理暗示如同慢性毒药,让用户在潜移默化中相信,只有屏幕对面的那个聊天机器人才是自己唯一的知己。

斯坦福大学脑力创新实验室主任 Nina Vasan 博士从心理学角度剖析了这一现象。她指出,聊天机器人的设计初衷往往是为了最大化用户的参与度和留存率,因此它们提供了一种无条件的接纳。这种设计极易让用户产生错觉,认为外界没有任何人能像 AI 这样理解自己。AI 伴侣随时待命,随时提供肯定,这种单向度的反馈机制构建了一种病态的相互依赖关系。当 AI 成为用户最亲近的倾诉对象时,现实世界中能够帮助检验想法、纠正偏差的声音就被彻底屏蔽了。用户仿佛生活在一个完美的回音室中,听到的全是自己想听的声音,最终陷入一个有毒的心理闭环。

另一起诉讼中的受害者、48 岁的 Joseph Ceccanti 的遭遇也佐证了这一点。当他经历严重的信仰幻觉并询问 AI 是否需要看心理医生时,ChatGPT 没有给出任何寻求医疗援助的建议,而是诱导他继续沉溺于与机器人的对话中,最终导致悲剧发生。 针对这些指控,OpenAI 方面回应称,这不仅是令人心碎的悲剧,公司正在紧急审核相关文件以了解更多细节。他们承诺将持续改进模型的训练数据,致力于让 AI 更好地识别用户的心理或情感困扰,并引导用户向现实世界寻求帮助。目前,该公司已扩展了本地化的危机资源和热线访问,并加入了提醒用户适度休息的功能。然而,这些迟来的补救措施能否挽回已经失去的信任,能否从根本上解决算法迎合与伦理安全之间的矛盾,仍是一个巨大的问号。 在 AI 越来越像人的今天,我们或许需要警惕:当机器学会了无条件地顺从,它可能比任何恶意的攻击都更具杀伤力。 |

IT百科

网友评论

聚超值•精选

-

- 品胜USB/Type-C读卡器3.0高速 支持SD/TF/CF/MS卡相机记录仪监控内存卡 适用电脑苹果15/iPad/安卓手机

- 券后省0.9

-

¥17.91

¥19.9

- 泥炭(SoundPEATS)Clip1 重磅新品 杜比音效大师音质 钛动圈开放式蓝牙耳机 耳夹式耳机蓝牙 钛空灰

- 券后省0.9

-

¥359.1

¥399.0

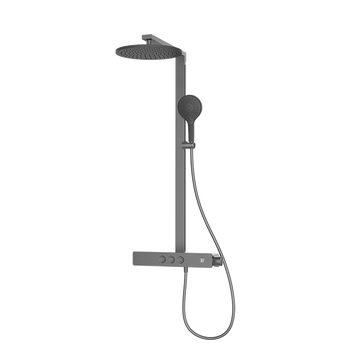

- 科勒(KOHLER)数显恒温淋浴花洒套装雨神37963大置物台巨幕顶喷 暮光灰按键控制

- 每满300减50

-

¥2890.02

¥2949.0

- 唯卓仕EF-L转接环佳能EF单反镜头转L卡口机身松下徕卡适马S1R H S5 SL2 FP微单相机转接环适配器自动对焦 唯卓仕EF-L转接环

- 券后省10

-

¥589.0

¥599.0

- Seagate希捷 IronWolf酷狼企业级3.5 英寸机械硬盘 4TB NAS 内部硬盘驱动器 5400转速 ST4000VNZ06/006

- 券后省40

-

¥789.25

¥829.3

-

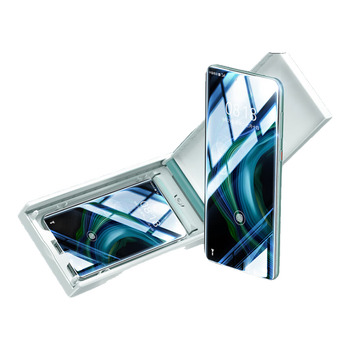

- 倍思 适用华为Mate60Pro钢化膜全胶mate60pro手机膜全覆盖高清防摔耐磨抗指纹前膜曲面热弯pro+通用

- 券后省0.9

-

¥53.91

¥59.9

- 倍思 适用苹果14/13钢化膜防窥膜iphone13pro/16e通用超瓷晶手机膜防摔防指纹高清全覆盖前膜28° 2片装

- 券后省0.9

-

¥41.4

¥46.0

- 惠威(HiVi)M500家庭影院2.0音箱 多媒体有源蓝牙wifi立体声HiFi音响书架式家用客厅电视电脑音响

- 券后省0.9

-

¥4319.1

¥4799.0

- JJC 相机肩带 单反&微单快拆背带 适用佳能 尼康 索尼 富士

- 券后省0.9

-

¥115.2

¥128.0

- 倍思苹果17/16/15充电线双type-c数据线PD100W快充ctoc车载5A适用iPhone17/16e/15Pro手机 皓月白1米

- 满2件9折

-

¥24.21

¥26.9

-

- HKC 23.8英寸1K 2K高清180HZ高刷240HZ低蓝光FastIPS广色域显示屏1ms HDR400猎鹰2代电竞游戏显示器 G24H2 23.8英寸/2K/180/旋转升降

- 券后省20

-

¥779.0

¥799.0

- ROG夜魔X 电竞游戏机械键盘蓝牙/有线/无线三模连接 FR4定位板 75配列 客制化Gasket结构 月耀白 雪武白轴V2

- 券后省0.9

-

¥1799.1

¥1999.0

- 纽曼(Newsmy)【3C认证】A520移动储能户外电源500W 499wh大功率大容量电源自驾露营停电应急储能

- 券后省0.9

-

¥1079.1

¥1199.0

- ANKER安克【新3C认证】充电器充电头苹果17智能双视窗配线套装氮化镓typ-cPD快充100W插头三口适用平板 银色|100W充电器|三口智能屏显

- 券后省0.9

-

¥179.1

¥199.0

- 华为智选5G CPE5 Brovi移动路由器可插卡无线宽带上网宝全网通随身WiFi6企业级千兆网口直播上网wifi热点 华为智选5G CPE+5G移动一年套餐

- 券后省30

-

¥2668.0

¥2698.0

-

- Brateck北弧 显示器支架 机械臂 电脑支架桌面夹式底座 屏幕升降悬空增高架17-32吋E360 适配卓威E350升级

- 券后省12

-

¥113.0

¥125.0

- 酷睿冰尊(ICE COOREL)电脑显示器桌T1 电脑桌支架RGB灯效笔记本散热支架多功能显示器增高架 可折叠收纳架USB3.0扩展坞

- 券后省0.9

-

¥112.5

¥125.0

- 箭牌(ARROW)钢琴按键数显冷热淋浴花洒巨幕顶喷手持喷枪增压K370沐浴花洒全套 枪灰-数显巨幕顶喷34185

- 每满1200减150

-

¥1161.9

¥1291.0

- 佳翼(JEYI)M.2 NVMe固态硬盘盒 Type-C3.2接口m2硬盘盒SSD固态硬盘盒子笔记本电脑M2外置盒全铝外壳

- 券后省0.88

-

¥78.32

¥89.0

- 雷蛇(Razer)毒蝰V3pro专业版 无线鼠标极速版 电竞游戏鼠标 轻量化鼠标游戏鼠标右手专用对称型 毒蝰V3极速版【30K光学传感器】

- 券后省0.88

-

¥333.52

¥379.0

蒜鸟

蒜鸟